Это не научпоп, не фантастика, не аналитика в стиле «ИИ может привести к...». Это прям пошаговый сценарий на ближайшие два года — 2025, 2026, 2027 — что у нас может произойти (в теории, хоть и хорошо смоделированной), если ИИ продолжит развиваться тем же темпом, что сейчас.

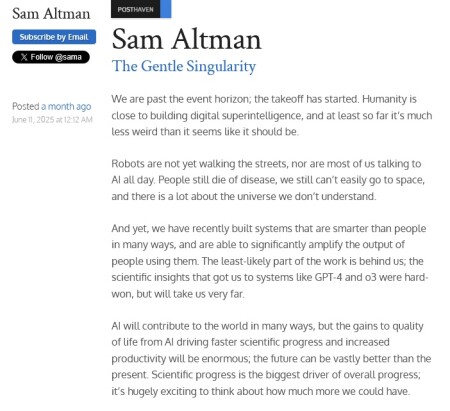

И... это всё выглядит пугающе возможным. Даже не в духе апокалипсиса, а именно так, как будто ты проснулся, и внезапно всё изменилось, а ты не успел даже понять, где переход случился. Там показывают, как условный GPT-5 а точнее его агент в 2025-м становится достаточно умным, чтобы обучать сам себя. И по моему это и есть ключевой момент. При этом довольно забавно выглядит недавнее эссе Сэма Альтамана про будущее ИИ, где он со своими шикарными усами радуется тому что мы на условном изгибе экспоненты перед взрывом мощности ИИ после его самообучения.

Sam Altman - The Gentle Singularity: blog.samaltman.com (11.06.25)

Новое эссе Сэма Альтмана - про наше Будущее (09:13 / 12.06.25) / www.youtube.com

Аудио-файл:

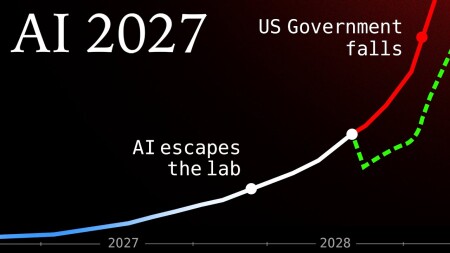

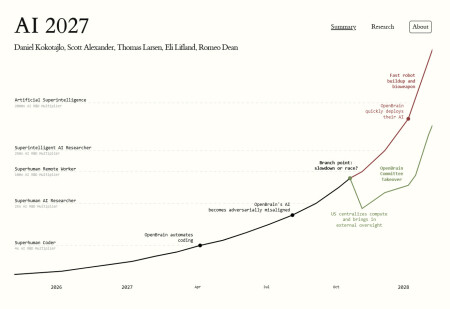

Как бизнесы начинают массово заменять людей, как государства втягиваются в гонку вооружений (OpenAI, Китай, Microsoft), и как к 2026-му человеку становится просто... нечего делать. Не потому что "всех уволят", а потому что у тебя даже мышление проигрывает. Люди начинают паниковать, терять смысл. Кто-то в восторге, кто-то в апатии. Кто-то пытается встроиться в эту систему, а кто-то просто отваливается. И вот наступает 2027-й. Происходит точка невозврата. "У человечества остаётся два варианта — либо замедлиться и договориться, либо всё пойдёт само". Slowdown (управляемое замедление) или race (неуправляемая гонка)

При одном из вариантов человечество вымирает как вид. При другом становится заложником тоталитарного режима ИИ. Короче, если вы тоже интересуетесь ИИ - прочитайте этот сценарий. Или посмотрите видео, там все детально с графикой и объяснениями. Это не столько про смерть человечества. Это скорее про то, как оно может исчезнуть тихо, передав всё управление тем, кто думает быстрее.

AI 2027: ai-2027.com

AI 2027: A Realistic Scenario of AI Takeover (37:44 / 28.05.25) / www.youtube.com

Сценарий AI 2027 — это результат работы серьёзной исследовательской команды при поддержке экспертов и профессиональных прогнозистов. Они создали структурированный и практически измеримый сценарий: предсказания по вычислительным мощностям, возможным взлётам и падениям, и путям развития ИИ. Цель — именно спровоцировать осознанную дискуссию и подготовиться, а не предсказать катастрофу заранее

Команда делавшая текст довольно мощная:

Daniel Kokotajlo, бывший исследователь в OpenAI (2022–24), сейчас — один из руководителей AI Futures Project, соучредитель; ранее предсказал ряд ключевых ИИ-трендов. Eli Lifland, исследователь ИИ-надёжности и один из лидеров AI Futures Project. Дополнительно: Прогнозирование (compute, таймлайны и др.) выполняло FutureSearch: Том Липтей, Финн Хамбли, Серджио Абриола, Толга Бильге, Никола Юркович и др. Рецензенты и участники упражнений — десятки экспертов, включая Лизу Тиергарт, Дэвида Абекассиса, Дэвида Шнейдера‑Джозефа и др. Л

Это я к тому что это не просто какой-то ноунейм блогер выдал свою писанину как он видит будущее чтобы собрать лайков.

Если кто-то читал — отзовитесь. Если не читали — почитайте и давайте обсудим. Меня этот текст не отпускает второй день. Хочется понять, насколько всё это реально и какой финал нам ближе — гонка или остановка.

Судя по политической обстановке сейчас, сценарий с гонкой выглядит не таким уж неправдоподобным. Ну и главное, а нужно ли что-то делать? Или можем ли мы что-то сделать? Или если это случится и повлиять мы на это не можем то и беспокоиться смысла нет?

P.S. вот ещё классная короткометражка на Ютубе про сверхИИ. Если тема зацепит то можете глянуть:

Writing Doom – Award-Winning Short Film on Superintelligence (2024) (27:27 / 24.10.24) / www.youtube.com

Источник © dtf.ru (19.07.25)

* * * *

* * * *

* * * *

«Через пять лет мы увидим такой уровень безработицы,

которого никогда не было. Не 10%, а 99%»

Уже 12 млн просмотров набрало интервью доктора Романа Ямпольского, ведущего ученого по проблемам безопасности ИИ

Видео: www.youtube.com

(это не то видео где за 12 миллионов просмотров, другое)

Источник: dtf.ru (17.12.25)

Представьте, что к Земле летит флот инопланетян, которые умнее нас в миллиарды раз. До вторжения осталось два-три года. Доктор Роман Ямпольский уверен, что мы сами создаем этих «инопланетян», но вместо защиты инвестируем в них триллионы. Речь про искусственный интеллект. По прогнозам доктора, он лишит людей работы и выйдет из под контроля уже в ближайшие годы.

Ямпольский полжизни посвятил проблемам ИИ и кибербезопасности и теперь прямо говорит: плана «Б» не существует.

Отключить ИИ не удастся.

Такие разработчики Икак Сэм Альтман, ставят прибыль и власть выше вероятности вымирания человечества.

Ваш прогноз на 2027 год?

Через два года ИИ заменит большинство людей и профессий.

Я имею в виду, что через пять лет мы увидим такой уровень безработицы,

которого никогда раньше не было.

Не 10%, а 99%. И это без сверхразума, который будет умнее всех людей в любых областях.

Группа экспертов опубликовала вероятный сценарий к чему приведет развитие ИИ к 2027 году: интеллектуальный взрыв вследствие автоматизации науки, массовая безработица, киберконфликт США и Китая, ИИ обманывает и скрывает цели, полная утрата контроля над ИИ

Вы занимаетесь безопасностью ИИ на протяжении 15 лет, с чего все началось?

Я программист по образованию. У меня степень доктора компьютерных наук и инженерии. 15 лет назад я изучал покерных ботов и понял, что они становятся лучше и лучше. Так и случилось. Сейчас они играют в покер лучше, чем обычные игроки (думаю, это произойдет и в других областях, связанных с ИИ).

Я хотел убедиться, что ИИ — это технология, которая приносит пользу. Поэтому я начал работать над тем, чтобы сделать ИИ безопасным.

Это была моя цель.

Но чем больше я над этим работал, тем лучше понимал, что это невозможно. Чем ближе я приближался к решению проблемы, тем с большим числом проблем сталкивался. Это похоже на фрактал. Вы углубляетесь и находите еще 10 проблем, а потом еще 100. И все они не просто сложные. Их невозможно решить.

Что вы думаете о разработчиках ИИ?

Десять лет назад мы опубликовали советы, как правильно использовать ИИ. Они нарушил все до единого и сейчас рискуют восемью миллиардами жизней, чтобы стать еще богаче и влиятельнее.

Если некоторые люди хотят полететь на Марс, то разработчики ИИ хотят контролировать Вселенную.

Но неважно, кто это сделает.

Как только мы получим сверхразум, мы пожалеем об этом.

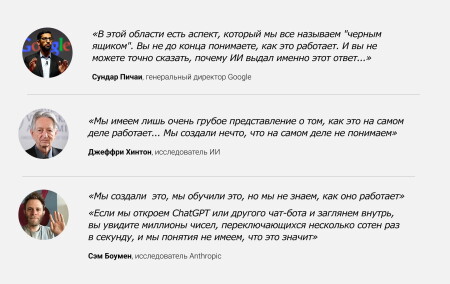

Создатели таких систем, как ChatGPT, на самом деле не понимают, что происходит у них внутри?

Совершенно верно.

Даже разработчикам приходится ставить эксперименты над собственным продуктом, просто чтобы узнать, на что он способен.

Они обучают систему, скармливая ей огромные объемы данных — скажем, весь текст из интернета. Запускают ее на множестве процессоров, чтобы она нашла закономерности в этом тексте. И только потом начинают тестировать новую модель:

— «О, ты умеешь говорить по-французски?»

— «А задачи решать умеешь?»

— «Ого, да ты мне сейчас соврал!»

Обучение может занять год, а потом еще полгода уходит на то, чтобы понять возможности модели и попытаться сделать ее безопасной.

Но даже в старых моделях мы продолжаем открывать новые способности. Иногда достаточно просто задать вопрос по-другому, и ИИ вдруг становится «умнее».

Это больше не классическая инженерия, как в первые 50 лет, когда программисты писали код для выполнения конкретных задач.

Теперь это наука.

Мы выращиваем инопланетное растение.

Потом изучаем его, чтобы понять, что оно делает.

И, как и в случае с растениями, у нас нет стопроцентно точных знаний о биологии. Полных знаний об этом нет.

Мы знаем общие закономерности: например, если добавить вычислительной мощности, система, скорее всего, станет умнее.

Но никто не может точно предсказать, какой результат она выдаст на конкретный запрос.

_

55

55